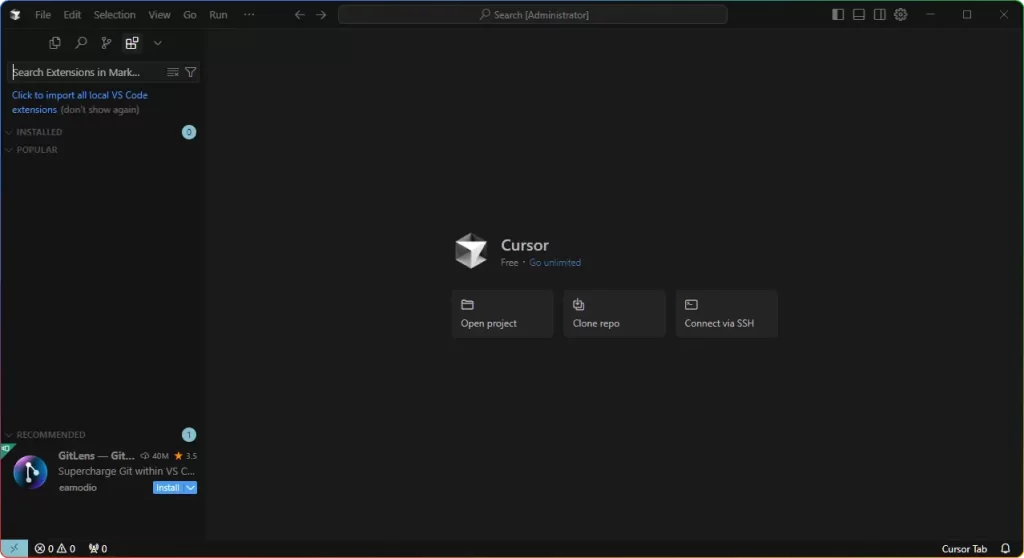

VideoCaptioner(卡卡字幕助手)是基于 LLM 的智能字幕工具,支持AI 字幕生成、语音识别、断句校正、字幕翻译全流程处理,无需高配置,支持在线与本地离线模式,高效输出专业字幕,适配各类视频创作需求。

![图片[1]-卡卡字幕助手VideoCaptioner v1.3.3:AI字幕生成工具 - 搜源站-搜源站](https://www.souyuanzhan.com/wp-content/uploads/01ef60c4bb20251202095433-1024x602.webp)

一、本地 Whisper 模型使用指南

2.1 模型下载

本地识别需先安装模型底包(CPU 版或 GPU+CPU 版),再选择适配的识别模型。模型体积与识别精度正相关,同时对设备性能要求逐步提升,各模型参数如下:

| 模型名称 | 大小 | 核心特点 |

|---|---|---|

| Tiny | 76.0 MB | 体积最小,识别速度快,适合低配设备 |

| Base | 145.0 MB | 平衡速度与精度,日常轻度使用首选 |

| Small | 484.0 MB | 精度提升明显,中等性能设备适配 |

| Medium | 1536.0 MB | 高精度识别,兼顾速度与效果 |

| Large-v1/v2/v3 | 3072.0 MB | 顶级识别精度,适合专业场景,需高性能设备 |

2.2 参数配置

- 打开软件 “Whisper 设置”,选择已下载的模型;

- 配置运行设备(CPU/GPU)与音频源语言(如中文);

- 调整 VAD 相关参数,优化语音识别断点准确性。

2.3 开始识别

将需要处理的视频或音频文件直接拖拽至软件界面,点击 “开始” 即可自动转录。识别速度取决于设备性能,核显或低配设备建议选择 Small 及以下轻量化模型。

二、LLM API 在线识别使用指南

3.1 接口配置

- 进入 “LLM 配置” 页面,输入 API Key、兼容 OpenAI 格式的 Base URL(需包含 /v1 后缀);

- 填写模型名称后点击 “检查连接”,成功后将自动填充可用模型列表(支持 gpt-3.5-turbo 等主流模型);

- 设置批处理大小(建议为 10 的倍数)与线程数,最大化利用云端算力。

3.2 核心优势

依托云端强大计算能力,LLM API 识别速度远超本地模型(高性能 GPU 设备除外);同时支持外文视频字幕翻译,通过 AI 优化让译文更地道专业,轻松解决 “生肉” 观影的语言障碍。

3.3 操作流程

在首页将转录模型切换为 “B 接口”,后续拖拽文件、字幕优化、导出等操作与本地 Whisper 模型完全一致,无需额外学习成本。

三、软件核心功能特点

- 双模式识别:支持本地 Whisper 模型与 LLM API 接入,满足不同设备性能与使用场景需求;

- 智能优化:基于 LLM 的智能断句与字幕校正,让字幕阅读更自然流畅,减少人工修改工作量;

- 高效批量处理:支持多文件同时字幕合成,批处理设计大幅提升创作效率;

- 多格式导出:可导出 SRT、ASS、VTT 等主流字幕格式,适配各类视频编辑软件与播放工具;

- 直观编辑:内置实时预览与快捷编辑界面,识别错误可手动修改,操作简单易上手;

- 低资源消耗:内置基础 LLM 模型,消耗 Token 少,核显设备也能稳定运行。

四、使用注意事项

- 使用本地 Whisper 模型前,需先安装对应版本底包(CPU 或 GPU+CPU),否则无法正常加载模型;

- 接入 LLM API 时,需确保 Base URL 格式正确(包含 /v1 后缀),API Key 有效,否则会连接失败;

- 模型下载后若无法识别,可尝试 “重新下载” 或检查模型文件夹路径是否正确;

- 批量处理时,建议按照软件提示设置批处理大小,避免因数量过多导致程序卡顿。

© 版权声明

THE END

暂无评论内容